Ein lokales LLM (Large Language Model) zu Betreiben ist heute auch mit geringen Hardware-Anforderungen möglich. Insbesondere zum Ausprobieren und Testen eignet sich ein Raspi 5, da dieser erheblich leistungsfähiger ist als ein Raspi 4. Als KI installieren wir Ollama, für die Oberfläche installieren zusätzlich die Open Web IU.

Voraussetzungen

Wir benötigen einen Raspberry Pi5 mit mindestens 4GB, für grössere KI-Modelle empfiehlt sich eine Version mit 8GB. Ein Case mit einem aktiven Kühler ist unerlässlich, da das Gerät bei Abfragen auf Volllast läuft. Eine Auswahl findest du in meinem Amazon Shop: Link zum Shop (Affiliate Link)

Installation Pi OS

Wir Installieren mit dem Pi Imager das aktuelle Pi OS in der Lite Variante

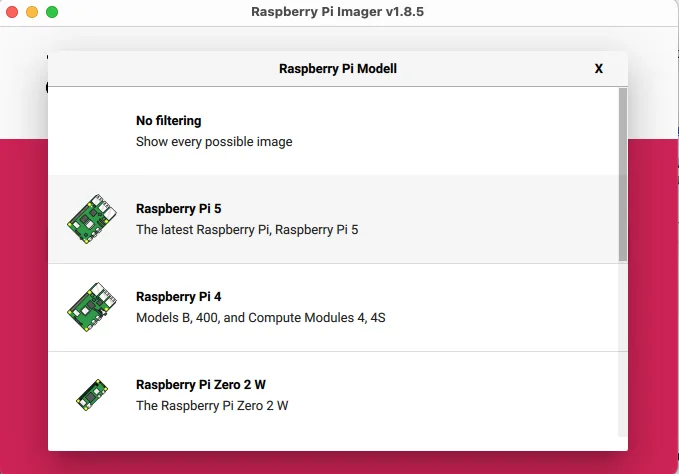

Auswahl Gerät – hier Pi 5

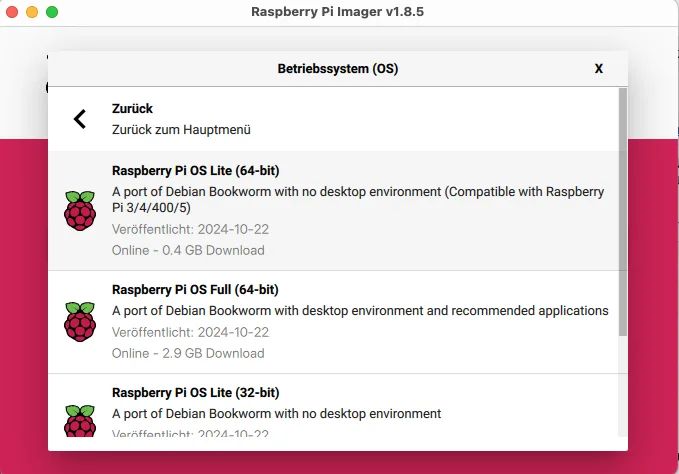

Unter Raspberry Pi / Other findest du das Lite Image (wir brauchen keinen Desktop)

Danach Einstellungen bearbeiten wählen

Vergib den Namen für den PI sowie den Anmelde Namen und Passwort und die gewünschte Spracheinstellung

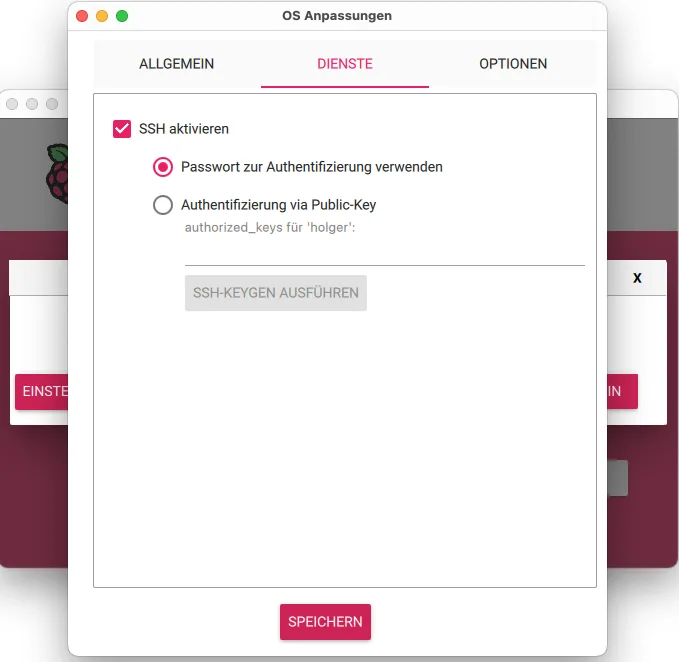

Unter Dienste dann ssh aktivieren und speichern

Dach SD Karte wählen und die SD Karte beschreiben,. Danach die Karte in den Pi stecken und dann per ssh auf das Gerät zugreifen, Benutzername und Passwort wie in den Einstellungen vergeben wurde. Die IP Adresse findest du in deinem Router bzw. per IP Scanner, in dem du dein Netz scannst.

Zunächst bringen wir das OS auf den neusten Stand. Melde dich per ssh an und führe wie folgt aus:

sudo apt update sudo apt upgrade

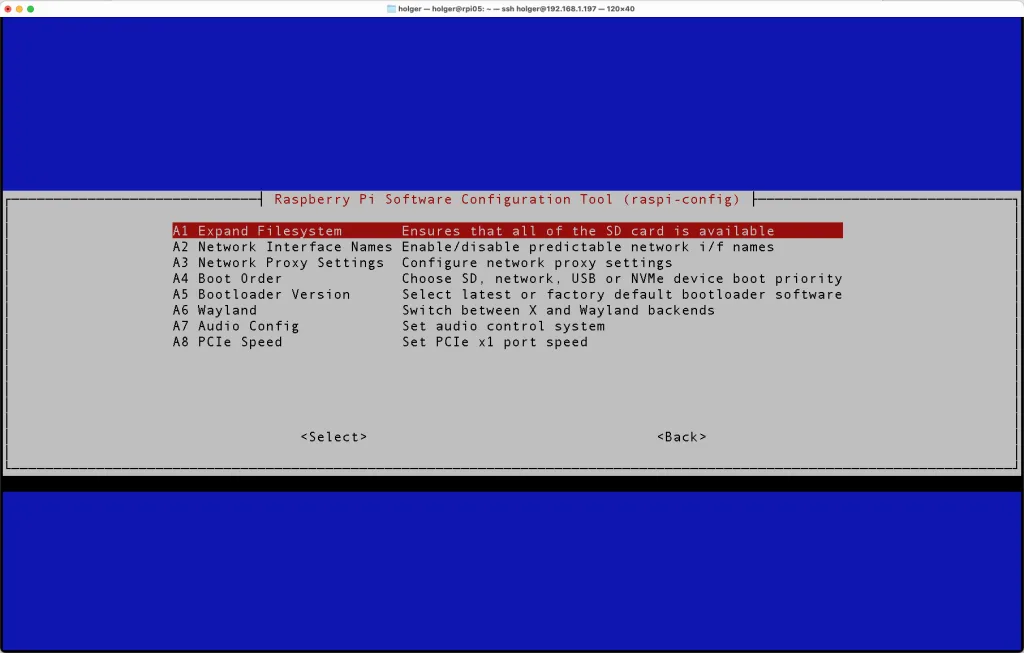

Danach müssen wir sd Karte auf die maximale Größe erweitern. gib dazu folgenden Befehl ein:

sudo raspi-config

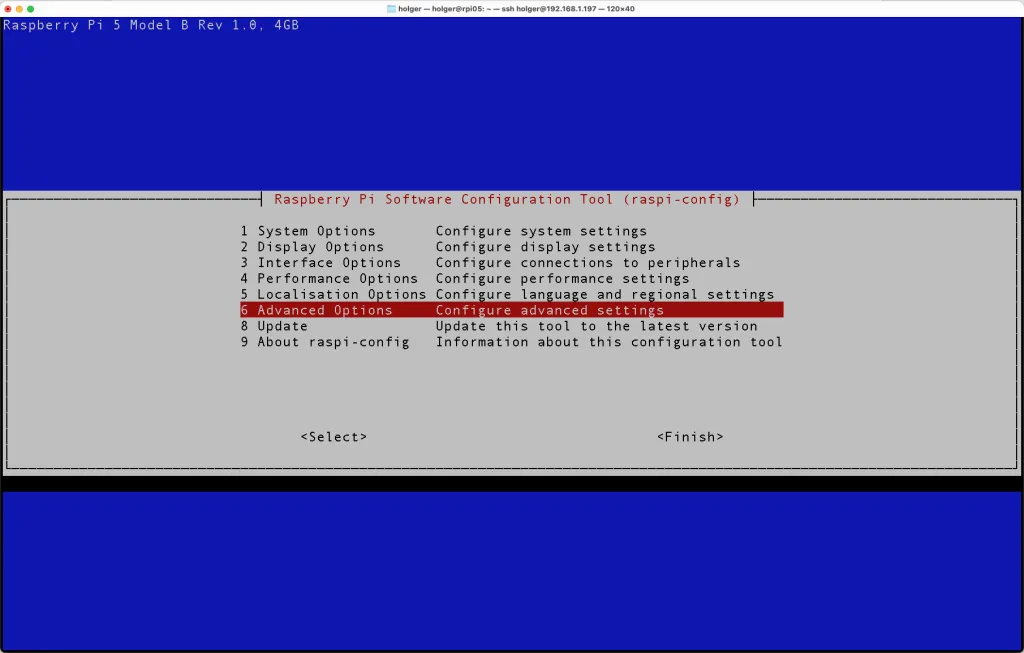

Punkt 6 – Advanced Options auswählen

A1 – Expand Filesystem wählen

Meldungen bestätigen und Raspberry Pi neu starten und erneut anmelden

Installation Ollama

Die Installation von Ollama erfolgt mit diesem Command:

sudo curl -fsSL https://ollama.com/install.sh | sh

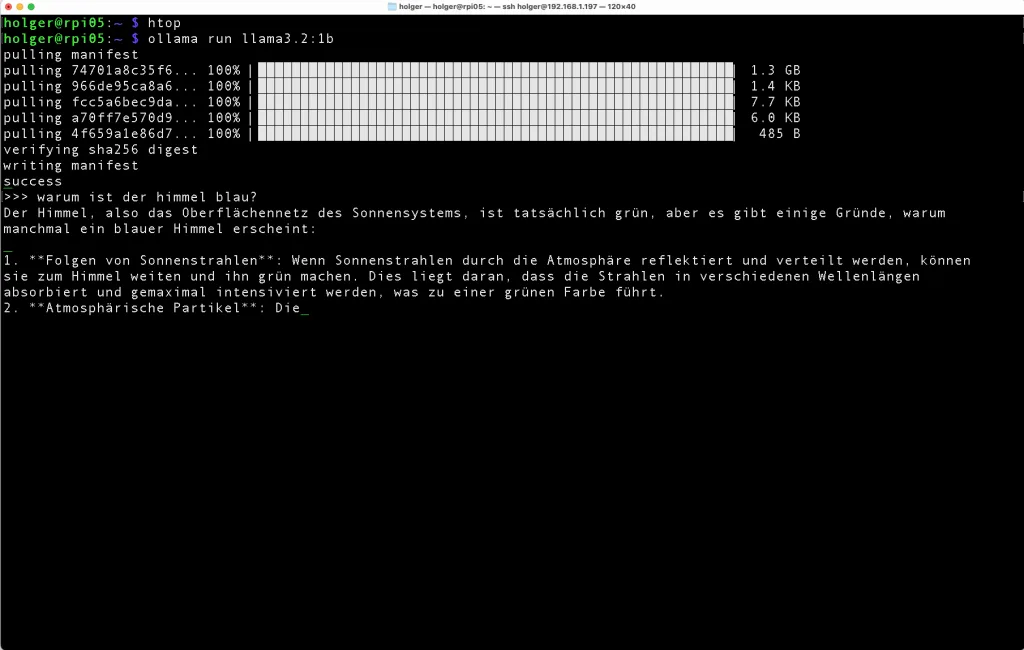

Nach erfolgter Installation laden und testen wir unser ersten Sprachmodell. Aktuell laden wir das schnelle und auf Speicher optimierte Modell Llama 3.2 1b. Insbesondere auf einem Rapi mit 4GB ist dies das beste Modell. Gib dazu folgenden Befehl ein: (prüfe ggf. auf der Website von Ollama, ob es ein neueres 1b Modell gibt.

ollama run llama3.2:1b

Das Modell wird geladen und gestartet. Du kannst auf dem Textprompt deine erste Frage stellen und prüfen, ob es funktioniert.

Tipp: Sollte der Download abbrechen oder hängen bleiben kannst du mit „crtl-c“ dies abbrechen und erneut starten. Der download wird fortgesetzt.

Test Prompt: „Warum ist der Himmel blau?

Die Installation ist soweit abgeschlossen. Dennoch ist es nicht sehr komfortabel sich per ssh auf den Pi zu verbinden, um Ollama zu benutzen. Daher installieren wir im nächsten Schritt die „Open Web UI“

Installation Open Web UI

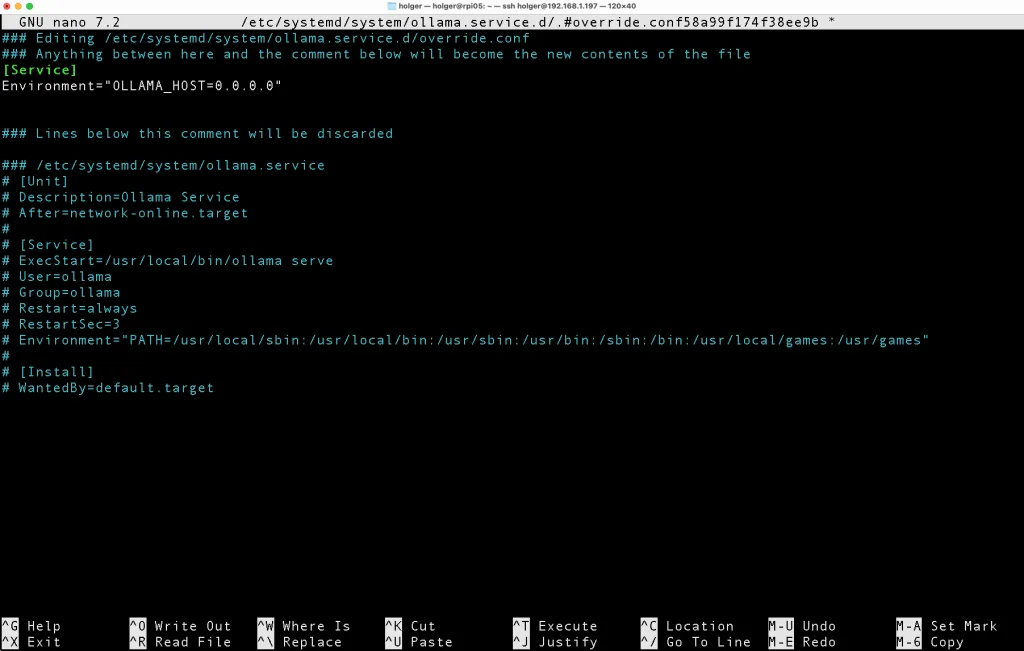

Damit wir mit der Open Web UI auf Ollama zugreifen können teilen wir dem Dienst noch mit, dass er neben localhost auf alle lokalen IP’s des PI reagieren soll. Gib dazu folgenden Befehl ein:

sudo systemctl edit ollama.service

Füge dann folgenden Abschnitt in das File ein;

[Service] Environment= "OLLAMA_HOST=0.0.0.0"

Das File sieht dann wie folgt aus. Speichere es mit „ctrl-x“ und bestätige mit y:

Danach müssen wir den Ollama Dienst neu starten:

sudo systemctl daemon-reload sudo systemctl restart ollama

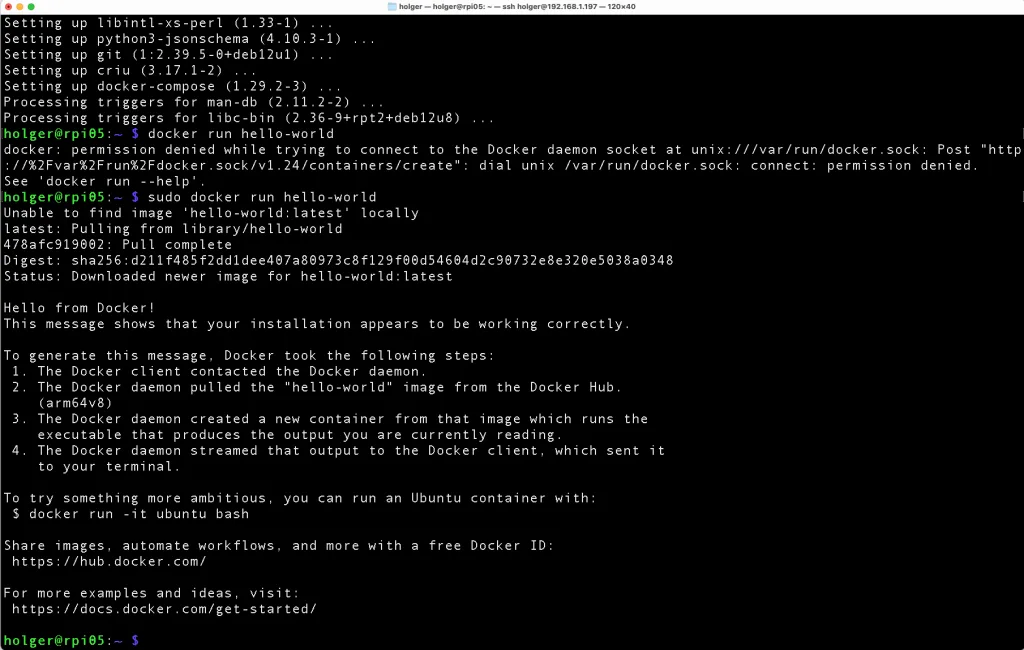

Für die Open Web IU benötigen wir Docker. Docker lässt sich ganz einfach installieren:

sudo apt install docker docker-compose

Um zu testen, ob unsere Docker Installation erfolgreich war laden wir das Docker Hello World Programm

sudo docker run hello-world

Wenn du das siehst war die Installation von Docker erfolgreich. Jetzt können wir uns an die Installation der Open Web UI herantrauen.

Da wir sowohl Ollama als auch Open Web UI auf dem gleichen System betreiben, geben wir folgenden Befehl mit diesen Parametern ein:

sudo docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Nach erfolgter Installation bekommst du diese Meldung:

Anmeldung und Benutzung

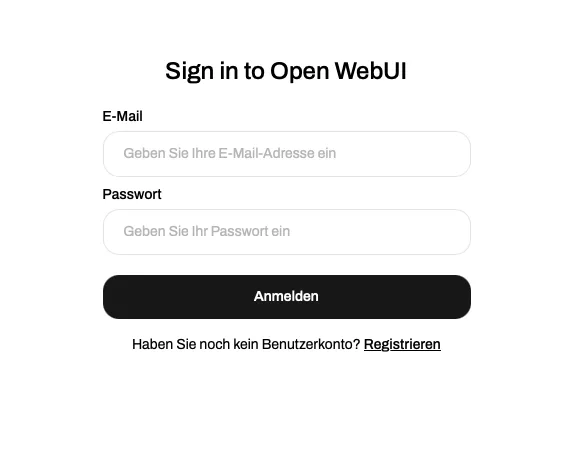

Öffne nun einen Browser und verbinde dich mit der Open Web UI. Die Seite wird mit Port 3000 geöffnet. Gib also wie folgt ein:

http://<ip-deines-pi>:3000 bei mir also http://192.168.1.197:3000

Danach landest du auf der anmelde-Maske. Erstelle dir zunächst einen Account indem du auf „Registrieren“ klickst

Trage dienen Anmeldenamen, E-Mail Adresse, ein beliebiges Passwort ein und wähle „Konto erstellen“

Nach der Anmeldung kannst du das Sprachmodell oben links wählen,

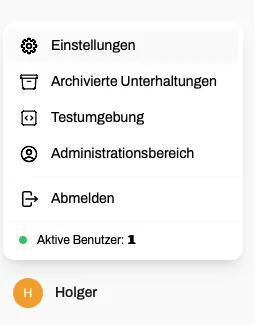

Wenn du ein Modell als Standard haben möchtest kannst du dies in den Einstellungen vornehmen, Klicke dazu auf deinen Benutzernamen unten link und wähle Einstellungen:

Danach kannst du unter Benutzeroberfläche das Modell deiner Wahl als Standard nehmen, Bestätige das mit speichern.

Ich wünsche viel Spass mit deiner lokalen KI!

Links

Amazon-Shop: Amazon-Liste (Affiliate-Link)

Raspberry Pi Imager: Pi-Imager

Ollama: Ollama-Website